В эпоху стремительного развития искусственного интеллекта большие языковые модели (LLM) стали важной частью технологического мира. Эти мощные инструменты могут генерировать текст, переводить языки, создавать разнообразный контент и информативно отвечать на вопросы. Однако обычно для работы с LLM используются облачные сервисы, что вызывает вопросы о конфиденциальности и зависимости от интернета. В связи с этим локальный запуск LLM становится все более популярным, позволяя пользователям работать с моделями прямо на своих компьютерах.

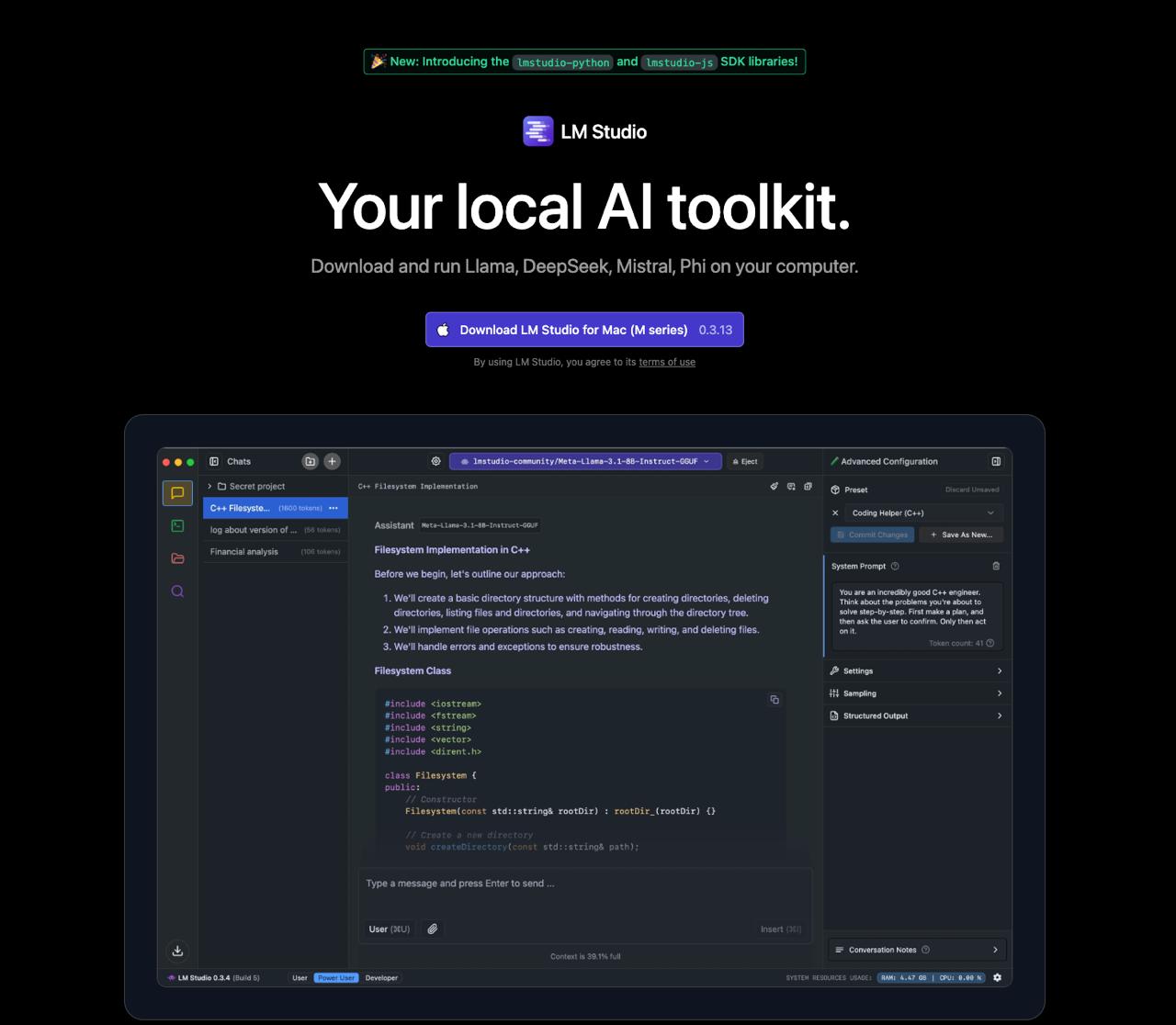

LM Studio – это настольное приложение для экспериментов с большими языковыми моделями (LLM) на вашем компьютере. Оно позволяет находить, загружать и использовать популярные модели, такие как Llama и Mistral. Приложение предлагает удобный чат-интерфейс и возможность работы с документами. Интерес к локальному запуску LLM растет из-за вопросов приватности и желания контролировать ресурсы без зависимости от интернета. Локальный запуск обеспечивает большую конфиденциальность и безопасность данных, так как информация не покидает компьютер пользователя. Кроме того, это позволяет работать без постоянного подключения к сети. Цель этой статьи – дать подробный обзор LM Studio, его основных функций и возможностей, а также объяснить, как оно упрощает работу с LLM локально.

Что такое LM Studio? Основные функции и возможности

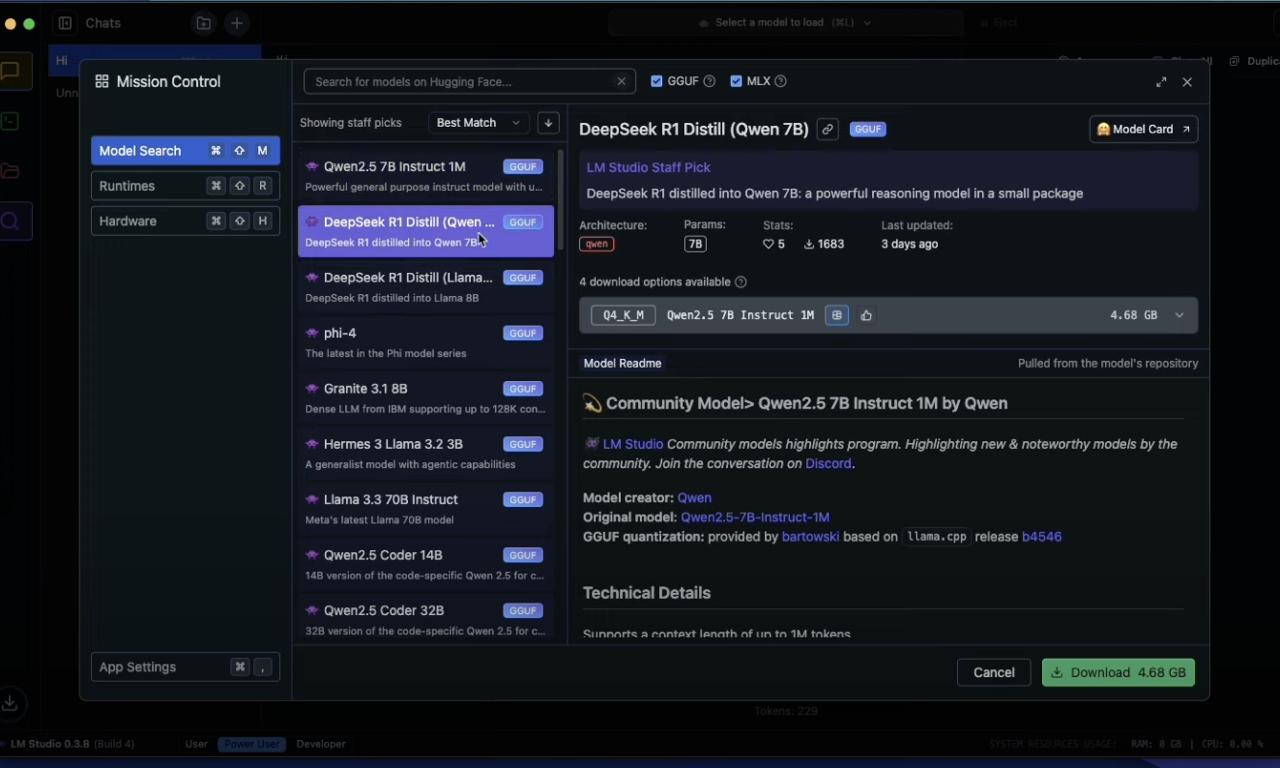

Это платформа, которая упрощает взаимодействие с большими языковыми моделями. Одна из ключевых функций – поиск и загрузка моделей из репозитория Hugging Face. Встроенный каталог позволяет искать по ключевым словам, таким как “llama”, “gemma” или “lmstudio”, а также по имени пользователя или названию модели. Приложение показывает подробную информацию о каждой модели, включая количество параметров, архитектуру и автора. Загрузка выбранной модели происходит одним кликом. Интеграция с Hugging Face делает LM Studio централизованной платформой для доступа к множеству предварительно обученных моделей, упрощая поиск и эксперименты.

После загрузки модели пользователи могут взаимодействовать с ней через интуитивно понятный чат-интерфейс, похожий на ChatGPT. Пользователи могут вводить запросы на любом языке. Интерфейс позволяет настраивать параметры модели, такие как длина ответа и стоп-строки. LM Studio поддерживает многооборотный чат, учитывая предыдущие сообщения для более контекстуального взаимодействия. Также есть возможность экспортировать историю чата в разных форматах. Простота использования делает LM Studio доступным для пользователей с разным уровнем подготовки, позволяя быстро начать работу с LLM без глубоких знаний в машинном обучении.

Для разработчиков LM Studio предлагает локальный сервер с поддержкой OpenAI-подобных эндпоинтов. Это позволяет интегрировать локально запущенные LLM в приложения и скрипты, используя совместимые библиотеки. Поддерживаются эндпоинты /chat/completions и /embeddings. Приложение предоставляет примеры запросов на Curl и Python, что облегчает интеграцию. Функция локального сервера делает LM Studio полезным инструментом для разработчиков, позволяя использовать локальные LLM в своих проектах без переписывания кода, предназначенного для OpenAI API.

LM Studio также предоставляет удобную систему управления локальными моделями и их настройками. Пользователи могут легко переключаться между загруженными моделями и экспериментировать с ними. Приложение позволяет настраивать различные параметры, такие как температура (случайность ответов), максимальное количество токенов и другие. Кроме того, можно сохранять и экспортировать пользовательские пресеты конфигураций. Гибкая система управления позволяет пользователям настраивать поведение LLM для разных задач и адаптировать приложение под свои нужды.

Важной особенностью LM Studio является поддержка работы с документами в офлайн-режиме с использованием Retrieval Augmented Generation (RAG). Эта функция позволяет загружать локальные документы в различных форматах, включая PDF, DOCX, TXT и CSV, и взаимодействовать с ними с помощью LLM без подключения к интернету. LM Studio позволяет загружать до пяти файлов одновременно, общим размером до 30 МБ. Модель анализирует содержание документов и предоставляет ответы на вопросы, ссылаясь на релевантную информацию. Это обеспечивает более точные и релевантные ответы, основанные на предоставленном контенте. Возможность работы с локальными документами в офлайн-режиме делает LM Studio ценным инструментом для обработки конфиденциальной информации и проведения исследований без риска утечки данных.

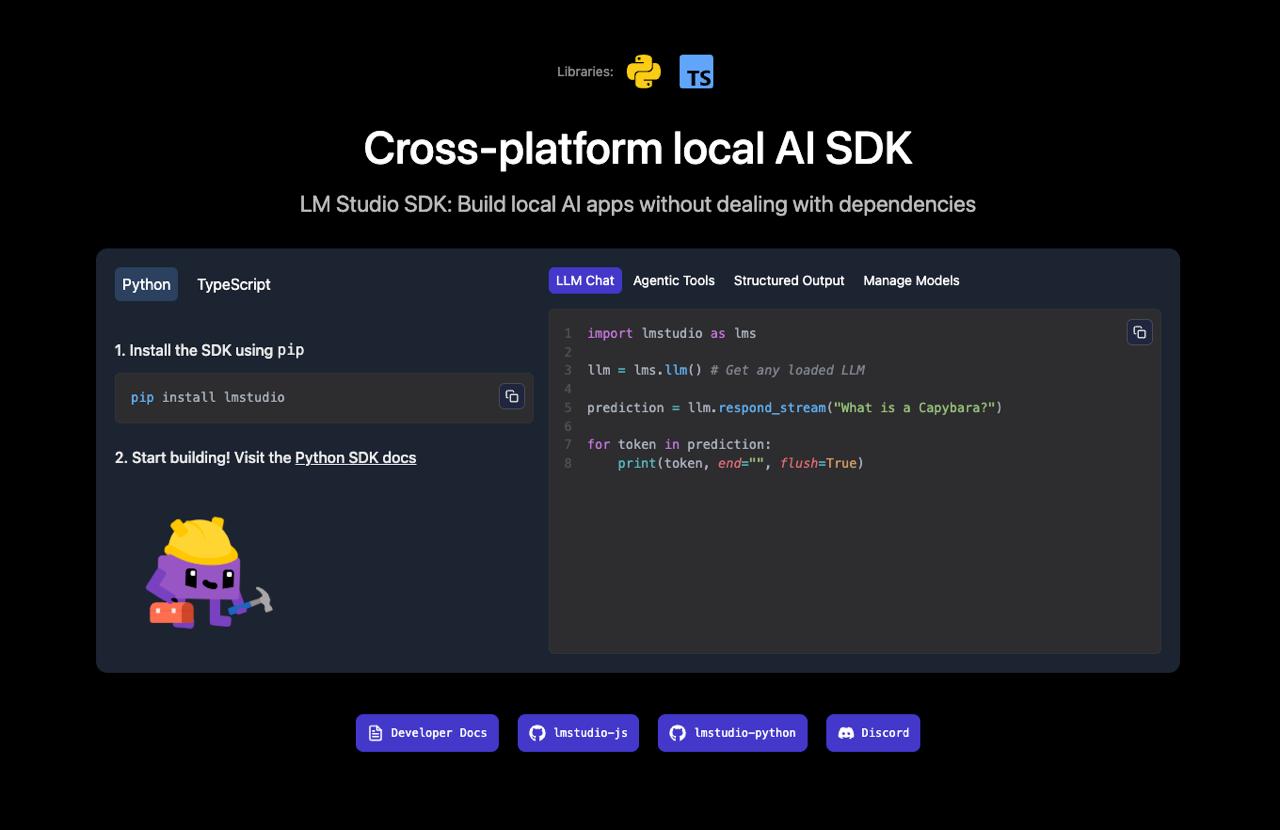

Для разработчиков LM Studio предлагает API и SDK для Python и TypeScript. Предоставляется REST API для взаимодействия с локально запущенными моделями из пользовательских приложений и скриптов. SDK для Python и TypeScript упрощают интеграцию с LM Studio. Эти SDK поддерживают основные API, включая Chat, Text Completions, Embeddings и Agentic Tool Use. Функция Agentic Tool Use (.act()) позволяет LLM запрашивать вызовы внешних функций и API, расширяя их возможности. SDK также автоматически управляют зависимостями (CUDA, Vulkan), поддерживают несколько GPU (NVIDIA, AMD, Apple) и совместимы с разными операционными системами (Windows, macOS, Linux). Предоставление SDK на популярных языках программирования, таких как Python и TypeScript, облегчает разработчикам использование возможностей LM Studio в своих проектах.

Ключевые преимущества использования LM Studio для локальной работы с LLM

Использование LM Studio для локальной работы с большими языковыми моделями дает ряд значительных преимуществ. Одним из важнейших является обеспечение полной конфиденциальности и безопасности данных. Поскольку LLM запускаются на компьютере пользователя, все данные остаются приватными и локальными, исключая риск их передачи на внешние серверы. Это особенно важно при работе с чувствительной информацией, такой как личные или корпоративные данные. Возможность локального запуска LLM, предоставляемая LM Studio, является значительным преимуществом для пользователей, работающих с конфиденциальной информацией.

Еще одно ключевое преимущество – возможность работы без постоянного подключения к интернету. В отличие от облачных сервисов, LM Studio не требует активного интернет-соединения, обеспечивая непрерывный доступ к возможностям LLM в любое время и в любом месте. Это особенно ценно при нестабильном интернет-соединении или в местах с ограниченным доступом к сети. Автономная работа LM Studio позволяет использовать LLM в любое время и в любом месте, независимо от наличия интернета, что повышает гибкость и удобство использования.

LM Studio отличается простотой использования и интуитивно понятным интерфейсом, что делает его доступным для широкого круга пользователей. Интерфейс приложения логично структурирован и включает разделы для поиска, загрузки моделей и взаимодействия через чат. Разработчики LM Studio упростили использование передовых библиотек с открытым исходным кодом, таких как llama.cpp, избавляя пользователей от необходимости самостоятельной компиляции или интеграции. Ориентация на простоту использования способствует более широкому распространению технологии локального запуска LLM.

Для личного использования LM Studio предоставляется бесплатно и не собирает пользовательские данные. Для коммерческого использования может потребоваться лицензия. Бесплатная модель использования для личных целей делает LM Studio привлекательным вариантом для индивидуальных пользователей и исследователей.

Наконец, использование LM Studio для локального запуска LLM может привести к экономии ресурсов по сравнению с облачными сервисами. Пользователи избегают платы за подписку или ограничений бесплатных тарифных планов, если их потребности в вычислительной мощности не чрезмерны. Кроме того, локальная обработка данных обеспечивает более быстрое время отклика и снижает задержку. Локальный запуск LLM с помощью LM Studio может быть более экономичным решением в долгосрочной перспективе.

LM Studio упрощает поиск, загрузку и запуск нейронок

LM Studio значительно упрощает работу с большими языковыми моделями благодаря интуитивному интерфейсу и интегрированным функциям. Поиск моделей осуществляется через встроенный каталог в разделе “Discover”. Пользователи могут просматривать список LLM из Hugging Face, использовать фильтры и искать по ключевым словам или авторам. LM Studio также предлагает подборку рекомендуемых моделей, таких как Llama 3 8GB и Stability AI. Удобный каталог моделей облегчает пользователям навигацию и выбор подходящих моделей.

Процесс загрузки выбранной модели очень прост и выполняется в один клик. После выбора модели в каталоге достаточно нажать кнопку “Download”, и LM Studio автоматически начнет загрузку. Приложение также показывает прогресс загрузки. Загрузка моделей в один клик устраняет технические сложности и делает начало работы с LLM максимально простым.

После загрузки модель готова к использованию. Запуск и взаимодействие происходят через раздел чата. LM Studio автоматически загружает модель по умолчанию при первом запуске. Пользователи могут выбрать любую загруженную модель из выпадающего меню в разделе чата и начать взаимодействие, введя свой запрос. Мгновенный запуск моделей и удобный чат-интерфейс позволяют пользователям быстро оценить возможности различных LLM и приступить к выполнению задач.

LM Studio обеспечивает широкую совместимость с различными форматами моделей и операционными системами. Приложение поддерживает запуск больших языковых моделей на Mac, Windows и Linux с использованием библиотеки llama.cpp, которая работает с моделями в формате GGUF. На компьютерах Mac с процессорами Apple Silicon также поддерживается формат MLX. LM Studio совместим с широким спектром моделей, использующих библиотеку тензоров ggml из проекта llama.cpp. Поддержка форматов GGUF и MLX обеспечивает широкую совместимость с большим количеством доступных LLM, оптимизированных для разных платформ.

Доступен для macOS, Windows и Linux. Приложение поддерживает компьютеры Mac с процессорами Apple Silicon (M1/M2/M3/M4), ПК с Windows на базе процессоров x64 или ARM64, а также ПК с Linux на базе процессоров x64. Для корректной работы на Windows и Linux может потребоваться процессор с поддержкой AVX2. Кросс-платформенная совместимость LM Studio позволяет пользователям на разных операционных системах использовать приложение для локального запуска LLM.

На рынке существует несколько альтернативных инструментов для локального запуска больших языковых моделей. Среди популярных – Ollama, GPT4All, Msty, Jan и Llamafile. Ollama ориентирован на запуск LLM через командную строку и REST API. GPT4All также является приложением для локального запуска LLM и может работать как сервер. Msty предлагает интуитивно понятный интерфейс и дополнительные функции, такие как интеграция с веб-поиском и RAG. Jan.ai и Llamafile также являются альтернативными решениями. На рынке есть несколько альтернативных решений для локального запуска LLM, каждое из которых имеет свои особенности и преимущества.

Для сравнения ключевых характеристик LM Studio и его основных конкурентов предлагается следующая таблица:

Функция | LM Studio | Ollama | GPT4All | Msty |

|---|---|---|---|---|

Операционные системы | macOS, Windows, Linux | macOS, Windows, Linux | macOS, Windows, Linux | macOS, Windows, Linux |

Форматы моделей | GGUF, MLX | GGUF | GGUF | GGUF, онлайн-модели |

GUI | Да | Нет (только CLI и REST API) | Да | Да |

API | Да (REST API, OpenAI-совместимый) | Да (REST API) | Да (как сервер) | Да (как сервер и клиент) |

SDK | Python, TypeScript | Нет | Нет | Нет |

Простота использования | Высокая | Средняя (требуется знание командной строки) | Средняя | Высокая |

RAG | Да | Нет (требуется интеграция) | Нет (требуется интеграция) | Да |

Цена | Бесплатно для личного использования | Бесплатно | Бесплатно | Бесплатно (большинство функций), есть платные |

Вокруг LM Studio сложилось активное сообщество пользователей. Основная площадка для общения – Discord-сервер LM Studio. Присоединившись к сообществу, пользователи могут задавать вопросы, делиться опытом и получать помощь от других участников и разработчиков. Разработчики также активно участвуют в обсуждениях на Discord и GitHub. Существуют даже проекты по интеграции LM Studio с Discord, например, разработка Discord-бота с использованием LM Studio SDK. Активное сообщество пользователей в Discord является ценным ресурсом для получения ответов на вопросы и обмена опытом.

Официальная документация по LM Studio доступна на сайте разработчика lmstudio.ai/docs. Документация содержит подробные руководства по установке, использованию основных функций, API и SDK. Отдельные разделы посвящены загрузке моделей, работе с документами и использованию API. Также представлена информация о системных требованиях и поддерживаемых форматах моделей. Подробная официальная документация облегчает освоение LM Studio и предоставляет ответы на большинство вопросов.

LM Studio представляет собой мощный и удобный инструмент для локального запуска больших языковых моделей, обеспечивающий конфиденциальность, автономную работу и интуитивно понятный интерфейс. Благодаря интеграции с Hugging Face, поддержке популярных форматов моделей и кросс-платформенной совместимости, LM Studio является отличным выбором для разработчиков, исследователей и всех, кто интересуется искусственным интеллектом.

Не упустите возможность исследовать потенциал больших языковых моделей на своем компьютере. Скачайте LM Studio сегодня и начните свои эксперименты! Присоединяйтесь к нашему сообществу, делитесь опытом и открывайте новые горизонты в мире локального AI.

Возможно будет интересно: